17.6. Cuadros de Mando en Pentaho con Community Dashboard Framework (CDF).

Posted by Roberto Espinosa en 20 julio 2010

CDF (Community Dashboard Framework) es un

conjunto de tecnologías Open Source que permite a los desarrolladores BI

construir cuadros de mando dinámicos y tableros (Dashboards) para la

plataforma BI de Pentaho. Los dashboards CDF son paginas web que

utilizan la tecnología Ajax para combinar informes, graficos, tablas

Olap y mapas.

Pentaho no esta directamente involucrado en el desarrollo de este proyecto, pero incluye el plugin correspondiente tanto en la versión Community como en la Enterprise. Igualmente, desarrolladores de Pentaho son contribuyentes activos al proyecto.

El proyecto fue iniciado por Ingo Klose en 2007 y posteriormente potenciado por el trabajo de Pedro Alves, que además colabora en otros proyectos dentro del ambito de Pentaho, como CDA (Community Data Access), CBF (Community Build Framework) o CDE (Community Dashboard Editor).

Podeís acceder a la documentación existente sobre CDF en el portal de Pentaho.

Pentaho no esta directamente involucrado en el desarrollo de este proyecto, pero incluye el plugin correspondiente tanto en la versión Community como en la Enterprise. Igualmente, desarrolladores de Pentaho son contribuyentes activos al proyecto.

El proyecto fue iniciado por Ingo Klose en 2007 y posteriormente potenciado por el trabajo de Pedro Alves, que además colabora en otros proyectos dentro del ambito de Pentaho, como CDA (Community Data Access), CBF (Community Build Framework) o CDE (Community Dashboard Editor).

Podeís acceder a la documentación existente sobre CDF en el portal de Pentaho.

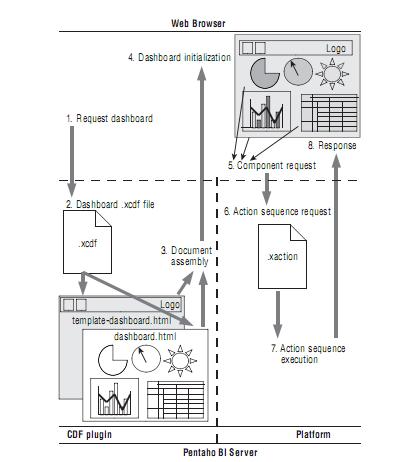

Arquitectura de CDF.

Los dashboards CDF son paginas web que contienen areas llamadas componentes, donde se visualiza contenido BI (informes, gráficos, tablas Olap,etc). Cuando ejecutamos un dashboard en la plataforma BI, se produce la siguiente secuencias de acciones para ejecutarlo en el servidor:- El usuario utiliza el navegador en la plataforma BI para abrir un tablero. Esto genera una request HTTP que es enviada al servidor BI de Pentaho.

- El servidor reconoce una petición de Dashboard e intenta localizar el fichero .xcdf asociado.

- El fichero .xcdf determina el template o plantilla del dashboard. Es un fichero HTML parcial que contiene los huecos para los componentes y las instrucciones Javascript para llenar estos componentes. El dashboard template se combina con la plantilla del documento (outer template) para generar una página web (documento HTML). Este segundo template se especifica igualmente en el fichero .xcdf.

4. La página es recibida por el navegador

para ser visualizada al usuario. Como parte de este proceso, se

inicializa el Dashboard y se ejecutan las instrucciones Javascript del

documento, generandose el contenido de los componentes.

5. Despues de la inicialización, se lanza la actualización de los componentes para realizar su llenado. Esto se realiza a través de las correspondientes requests contra el servidor.

6. El servidor Pentaho recibe las solicitudes recibidas por los componentes, que normalmente corresponden a la ejecución de secuencias de acciones (action sequence).

7. El servidor ejecuta la secuencia de acciones.

8. El contenido generado por la secuencia de acciones es enviado como resultado, y es procesado para ser incluido en la pagina web. El resultado llena el correspondiente componente, lo que permite que el resultado sea visible en la página.

Además, en la configuración del plugin se determinan unos templates

generales que determinan el marco en el que se visualizan los dashboards

y que son totalmente personalizables.5. Despues de la inicialización, se lanza la actualización de los componentes para realizar su llenado. Esto se realiza a través de las correspondientes requests contra el servidor.

6. El servidor Pentaho recibe las solicitudes recibidas por los componentes, que normalmente corresponden a la ejecución de secuencias de acciones (action sequence).

7. El servidor ejecuta la secuencia de acciones.

8. El contenido generado por la secuencia de acciones es enviado como resultado, y es procesado para ser incluido en la pagina web. El resultado llena el correspondiente componente, lo que permite que el resultado sea visible en la página.

Ejemplo práctico de CDF.

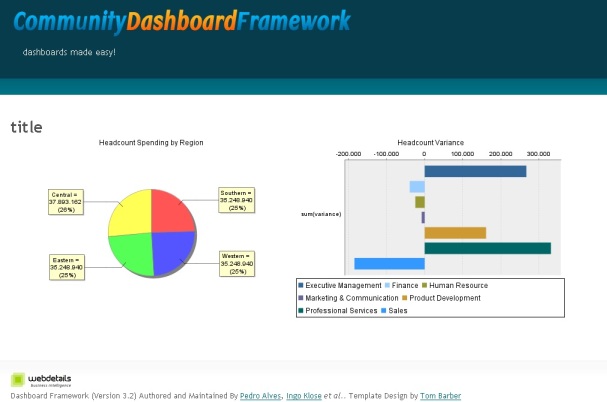

Para entender mejor los diferentes elementos que intervienen en la construcción de un dashboard CDF, vamos a ver un ejemplo práctico sencillo detallando todos los componentes que forman el tablero. Partiendo de uno de los ejemplos que se proporcionan en el portal de Pentaho, que tiene el siguiente aspecto:

Es un tablero interactivo, de forma que

podemos pulsar en cada una de las áreas del gráfico de la izquierda. Al

pulsar cada sección, se actualiza de forma automática el gráfico de

barras de la derecha, con los resultados de la región seleccionada. Para

construir un tablero como el del ejemplo, en primer lugar construiremos

el fichero .xcdf, donde estableceremos las propiedades generales, así

como el nombre del fichero que contiene el outer template. Este será el

fichero pentaho_sample.xcdf del tablero de la imagen:

<?xml version="1.0" encoding="UTF-8"?> <cdf> <title>Pentaho Sample</title> <author>Webdetails</author> <description>Pentaho Sample</description> <icon></icon> <template>template.html</template> </cdf>

En segundo lugar, construiremos el fichero

template. html, que incluye la parte html y la parte Javascript que va a

determinar como se llenan los diferentes componentes del tablero y como

es el comportamiento dinámico de este al pulsar sobre las secciones del

gráfico de tarta para ver el desglose de cada una de las zonas.

<SCRIPT LANGUAGE="JavaScript">

// This is a custom function that is fired when a user selects a productLine and then want to select a territory

// Its purpose is to reset the productLine variable back to null and pass the territory that has been selected

// The function is executed from the url-template tag in the territorySales.xaction

function clickOnRegion(value) {

department = "null";

Dashboards.fireChange('region',value);

}

</SCRIPT> ## PARTE HTML DONDE DEFINIMOS LAS SECCIONES Y LAS ETIQUETAS HTML QUE LUEGO SERAN SUSTITUIDAS POR LOS COMPONENTES CDF ##

<!-- The page_title_object -->

<h1><span id=page_title_object></span></h1>

<!-- The dashboard layout table -->

<table align="center" cellpadding="3">

<tr>

<td align="center"><div id="RegionsPieChartObject"></div></td>

<td align="center"><div id="RegionVarianceBarChartObject"></div></td>

</tr>

<tr>

<td align="center"><div id="DepartmentDialChartObject"></div></td>

<td align="center"><div id="EmbeddedReportObject"></div></td>

</tr>

</table>

<script language="javascript" type="text/javascript">

// Define script variables before script execution

var region = "null";

var department = "null"; ## DEFINICION DE LOS DIFERENTES COMPONENTES, CON SUS PROPIEDADES y FUNCIONES A EJECUTAR ANTES Y DESPUES DE LA EJECUCION DE CADA UNO

// pageTitleString component generates the page title with any other parameters is may need to construct the string

pageTitleString =

{

name: "pageTitleString",

type: "text",

listeners:["region", "department"],

htmlObject: "page_title_object",

executeAtStart: true,

expression: function(){return "title"},

preExecution:function(){

if(region == "null" && department == "null") {

title="Select a region";

}

else if (region != "null" && department == "null") {

title="This is headcount spending for " + region;

}

else if (region != "null" && department != "null") {

title = "This is headcount spending for " + region + ", " + department;

}

},

postExecution:function(){}

}

// RegionsPieChart component generates the

RegionsPieChart =

{

name: "RegionsPieChart",

type: "xaction",

solution: "bi-developers",

path: "cdf-samples/20-samples/pentaho_sample",

action: "RegionsPieChart.xaction",

listeners:[],

parameters: [],

htmlObject: "RegionsPieChartObject",

executeAtStart: true

}

// RegionVarianceBarChart component generates the

RegionVarianceBarChart =

{

name: "RegionVarianceBarChart",

type: "xaction",

solution: "bi-developers",

path: "cdf-samples/20-samples/pentaho_sample",

action: "RegionVarianceBarChart.xaction",

listeners:["region"],

parameters: [["REGION","region"]],

htmlObject: "RegionVarianceBarChartObject",

executeAtStart: false,

preExecution:function(){document.getElementById('DepartmentDialChartObject').innerHTML="";document.getElementById('EmbeddedReportObject').innerHTML="";}

}

// DepartmentDialChart component generates the

DepartmentDialChart =

{

name: "DepartmentDialChart",

type: "xaction",

solution: "bi-developers",

path: "cdf-samples/20-samples/pentaho_sample",

action: "DepartmentDialChart.xaction",

listeners:["department"],

parameters: [["DEPARTMENT","department"],["REGION","region"]],

htmlObject: "DepartmentDialChartObject",

executeAtStart: false

}

// EmbeddedReport component generates the

EmbeddedReport =

{

name: "EmbeddedReport",

type: "xaction",

solution: "bi-developers",

path: "cdf-samples/20-samples/pentaho_sample",

action: "embedded_report.xaction",

listeners:["department"],

parameters: [["DEPARTMENT","department"],["REGION","region"]],

htmlObject: "EmbeddedReportObject",

executeAtStart: false

} ## DEFINICION DE LOS COMPONENTES A SER CARGADOS EN EL DASHBOARD Y LA FUNCION PRINCIPAL DE CARGA DEL TABLERO

// These are the components to be loaded into the dashboard withing the [] seperated by ,

var components = [pageTitleString, RegionsPieChart, RegionVarianceBarChart, DepartmentDialChart, EmbeddedReport];

</script>

<script language="javascript" type="text/javascript">

// The intial dashboard load function definition

function load(){

Dashboards.init(components);

}

// The intial dashboard load function execution

load();

</script>

Como vemos, todo es

programación y somos nosotros los que hemos de indicar el comportamiento

de los diferentes elementos, compaginandolos con elementos de diseño

HTML. En la documentación de CDF

se enumeran las propiedades que se pueden definir y los componentes que

podemos utilizar dentro de los tableros. Por ejemplo, podremos

configurar los siguientes tipos de componentes:

check:

crea una lista de casillas de seleccion etiquetadas con los resultados

de una determinada secuencia de acciones (leyendo, por ejemplo, de la

base de datos).

dateInput: crear un control de calendario para introducción de fechas.

radio: crea una lista de radiobuttons etiquetados con los resultados de una determinada secuencia de acciones.

select: crear una lista de selección simple, que esta llena con los valores recuperados por una determinada secuencia de acciones.

selectMulti: igual que el anterior, pero la lista permite selección multiple.

text: permite actualizar el texto de una cadena HTML.

textInput: crea un campo de entrada de texto.

xaction: ejecuta una secuencia de acciones y visualiza los resultados en una determinada etiqueta HTML.

jpivot: ejecuta una secuencia de acciones jpivot y visualiza los resultados en un frame donde la tabla jpivot es embebida.

map: componente para integrar mapas.

mapBubble: componente para integrar gráficos.

Con el componente jpivot

podremos embeber una tabla de análisis dentro del tablero. Con xaction

podremos definir una secuencia de acciones (como ejecutar un informe,

por ejemplo). Aunque no la hemos analizado, Pentaho proporciona la

herramienta llamada Design Studio (PDS),

basada en el entorno Eclipse, que nos permite crear secuencias de

acciones para integrar en el servidor BI. Por ejemplo, podremos crear

secuencias de acciones para ejecutar informes o sentencias SQL, para

enviar correos electrónicos, obtener datos desde Kettle, realizar

acciones sobre el scheduler de la plataforma BI, etc. Podeís ver un

resumen de las acciones mas usuales en este link.

Los ficheros de secuencia de acciones tiene la extensión .xaction. Un

ejemplo de fichero de este tipo para ejecutar un report de PRD es el

siguiente:

<?xml version="1.0" encoding="UTF-8"?>

<action-sequence>

<title>JFreeReport HTML Example</title>

<version>1</version>

<logging-level>debug</logging-level>

<documentation>

<author>James Dixon</author>

<description><![CDATA[

This is an example of an HTML report produced by JFreeReport.

<p/>It shows the actual headcount cost, budgeted headcount

cost, and variance for every position in the specified

department and region

]]></description>

<icon>/style/icons/jfree1.png</icon>

<help/>

<result-type>none</result-type>

</documentation>

<inputs>

<REGION type="string">

<sources>

<request>REGION</request>

</sources>

<default-value><![CDATA[Southern]]></default-value>

</REGION>

<DEPARTMENT type="string">

<sources>

<request>DEPARTMENT</request>

</sources>

<default-value><![CDATA[Sales]]></default-value>

</DEPARTMENT>

</inputs>

<outputs>

<report type="content">

<destinations>

<response>content</response>

</destinations>

</report>

</outputs>

<resources>

<report-definition>

<solution-file>

<location>embedded_report.xml</location>

<mime-type>text/xml</mime-type>

</solution-file>

</report-definition>

</resources>

<actions>

<action-definition>

<component-name>SQLLookupRule</component-name>

<action-type>Query For Report Data</action-type>

<action-inputs>

<REGION type="string"/>

<DEPARTMENT type="string"/>

</action-inputs>

<action-outputs>

<query-result type="result-set" mapping="reportData"/>

</action-outputs>

<component-definition>

<jndi>SampleData</jndi>

<query><![CDATA[select QUADRANT_ACTUALS.REGION,

QUADRANT_ACTUALS.DEPARTMENT,

QUADRANT_ACTUALS.POSITIONTITLE,

QUADRANT_ACTUALS.ACTUAL,

QUADRANT_ACTUALS.BUDGET,

QUADRANT_ACTUALS.VARIANCE

from QUADRANT_ACTUALS

where QUADRANT_ACTUALS.REGION in ( {PREPARE:REGION} )

and QUADRANT_ACTUALS.DEPARTMENT in ( {PREPARE:DEPARTMENT} )

order by QUADRANT_ACTUALS.REGION, QUADRANT_ACTUALS.DEPARTMENT]]></query>

</component-definition>

</action-definition>

<action-definition>

<component-name>JFreeReportComponent</component-name>

<action-type>Pentaho Report</action-type>

<action-inputs>

<data type="result-set" mapping="reportData"/>

</action-inputs>

<action-resources>

<report-definition type="resource"/>

</action-resources>

<action-outputs>

<report-output type="content" mapping="report"/>

</action-outputs>

<component-definition>

<output-type>html</output-type>

</component-definition>

</action-definition>

</actions>

</action-sequence>

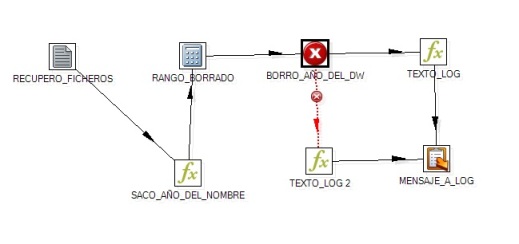

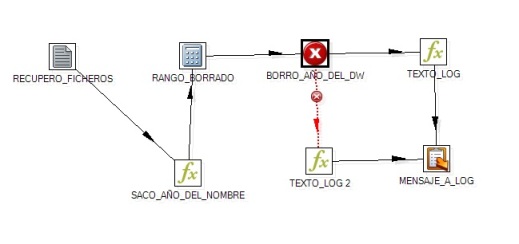

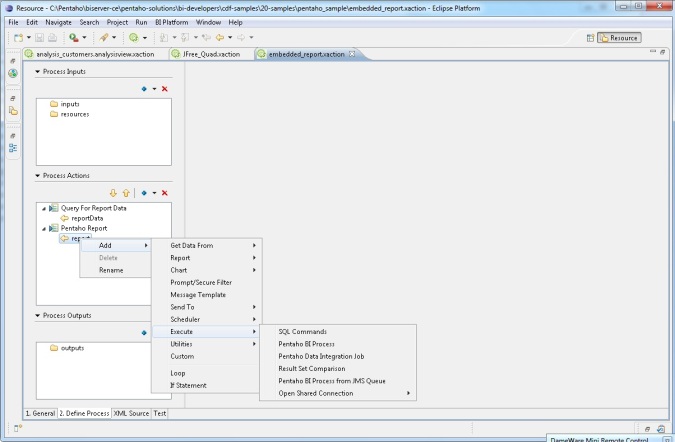

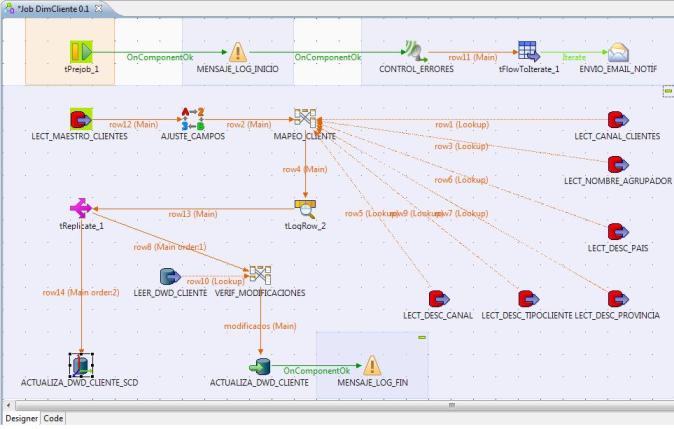

En la imagen podeis ver la interfaz de PDS, y

un ejemplo de una secuencia de acciones, que se compone básicamente de

inputs, acciones (como las que enumeramos anteriormente) y outputs. Los

ficheros xaction son publicados en el portal para integrar las acciones

descritas en él. Nos puede ser muy útil para automatizar procesos o para

distribuir resultados de la ejecución de informes y graficos.

Como os podeís imaginar, el diseño de los

tableros con CDF es todo un reto donde hemos de tener conocimientos

profundos en diseño Web, Javascript y además conocer de forma completa

el funcionamiento del portal BI y la forma de diseñar secuencias de

acciones con Pentaho Design Studio. Podremos construir casi todo lo que

queramos, pero con un elevado componente de programación que exige un

skill técnico muy elevado, en el que seguramente será necesaria la

intervención de varias personas, además del conocimiento del negocio

propio de un sistema BI.

17.5. Cubos Olap y navegación dimensional con Mondrian y Jpivot.

Posted by Roberto Espinosa en 20 julio 2010

Pentaho Analysis Services es la parte de la

plataforma BI de Pentaho que nos proporciona las funcionalidades Olap

para el análisis de la información. Nos permite, de una forma

interactiva, analizar los datos del Data Warehouse a traves de una

interfaz de tabla cruzada donde podemos navegar por las diferentes

dimensiones definidas en el modelo dimensional.

En una entrada anterior del blog, vimos la forma de definir nuestro modelo dimensional utilizando Pentaho Schema Workbench, aunque disponemos de otra herramienta adicional para la construcción de tablas agregadas, llamada Pentaho Agregation Designer (que permite mejorar la velocidad de ejecución de los análisis).

Una vez definidos los módelos dimensionales, podemos ejecutar nuestros análisis utilizando Jpivot a nivel de interfaz de usuario y Mondrian a nivel del servidor (es la parte que recibe las solicitudes de información de Jpivot, realiza las consultas contra la base de datos y devuelve la información en formato multidimensional).

Vamos a ver un poco como funciona la plataforma utilizando estos componentes y a continuación detallaremos las características mas importantes de Jpivot.

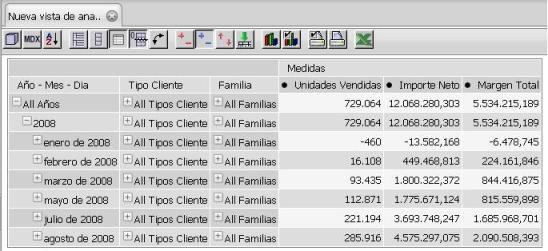

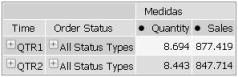

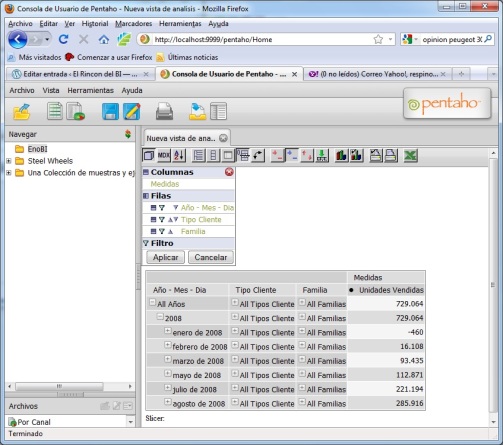

A continuación, nos aparecerá una tabla de Jpivot por defecto, donde aparecerán todas las dimensiones de análisis definidas en el cubo y los indicadores por defecto, con una única linea de resultados totales. Este será el punto de partida sobre el que iremos puliendo nuestro análisis hasta dejarlo de la forma que cumpla nuestros requerimientos de información.

Esta tarea de modificación de los análisis no será siempre necesaria, pues una vez los tengamos preparados, los podremos guardar y reejecutar, manteniendo la configuración de dimensiones, jerarquías, filtros e indicadores de análisis que tuviera la tabla en el momento de ser guardada. Vamos a ver las diferentes opciones de la interfaz de usuario de Jpivot.

La interfaz de usuario de JPivot es muy sencilla. Básicamente, disponemos de una barra de herramientas con botones donde podemos configurar las propiedades que va a tener la tabla donde visualizamos los resultados de los análisis. Veamos uno por uno cada botón (de izquierda a derecha) de la interfaz de usuario.

Navegador Olap

El primer botón de la barra de herramientas es el navegador Olap que nos permite configurar como Jpivot muestra la información de los cubos en la tabla pivot. Con la herramienta podemos definir que dimension y jerarquia aparece en cada uno de los ejes (filas/columnas), los indicadores que visualizamos en el análisis, filtros, etc. Podemos ir moviendo los diferentes elementos de una sección a otra pulsando los correspondientes iconos a la izquierda de cada elemento hasta dejar el análisis personalizado a nuestra necesidades.

En una entrada anterior del blog, vimos la forma de definir nuestro modelo dimensional utilizando Pentaho Schema Workbench, aunque disponemos de otra herramienta adicional para la construcción de tablas agregadas, llamada Pentaho Agregation Designer (que permite mejorar la velocidad de ejecución de los análisis).

Una vez definidos los módelos dimensionales, podemos ejecutar nuestros análisis utilizando Jpivot a nivel de interfaz de usuario y Mondrian a nivel del servidor (es la parte que recibe las solicitudes de información de Jpivot, realiza las consultas contra la base de datos y devuelve la información en formato multidimensional).

Vamos a ver un poco como funciona la plataforma utilizando estos componentes y a continuación detallaremos las características mas importantes de Jpivot.

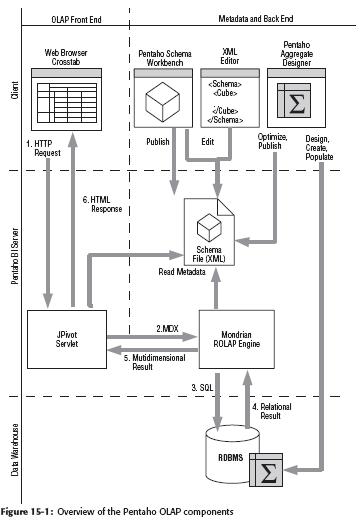

Arquitectura de PAS.

Cuando un usuario realiza un análisis a través de Pentaho Analysis Services, se realiza la siguiente secuencia de acciones entre los diferentes componentes que forman la plataforma:- Cuando estamos conectados a la plataforma BI y lanzamos la ejecución de un nuevo análisis, o interactuamos en un análisis ya visualizado (haciendo un drilldown por los datos, por ejemplo, o modificando la vista de los datos o los filtros), se produce una request HTTP, que provoca una secuencia de acciones sobre Jpivot.

- El servlet Jpivot recibe la solicitud y la traduce/transforma a una query en lenguaje multidimensional MDX, que es enviada a Mondrian (nuestro servidor ROLAP).

- Mondrian interpreta la query MDX y la traduce en una o mas sentencias SQL, que son enviadas a la base de datos relacional.

- La base de datos relacional ejecuta las sentencias SQL enviadas por Mondrian y le devuelve los resultados en forma de tabla (la forma tipica de visualizar resultados en cualquier motor de base de datos relacional utilizando el lenguaje de interrogación SQL).

- Mondrian procesa los resultados y los traduce a un set de resultados multidimensional. Este set de datos sería la respuesta a la query MDX del punto 2.

- Jpivot utiliza los resultados multidimensionales para construir una página HTML para visualizar la información, con la interfaz propia que veremos a continuación.

Arquitectura de Pentaho Analysis Services

La base para el correcto funcionamiento del

sistema y de los diferentes componentes que lo forman, es la definición

de los esquemas dimensionales y sus cubos, que habremos realizado

previamente utilizando PWD. Mondrian viene instalado en la plataforma BI

de Pentaho como un componente integrado. Si quereis profundizar en

aspectos concretos de su funcionamiento y configuración, os recomiendo

la lectura de la documentación que Pentaho proporciona en su portal.

Jpivot.

Jpivot es el cliente que vamos a utilizar para visualizar los resultados de los análisis. Para ejecutar un análisis, podemos utilizar uno ya existente que habremos guardado en la correspondiente carpeta de la plataforma, o bien crear uno nuevo desde la opción Nueva vista de análisis, momento en el que se nos pedirá el esquema y el cubo sobre el que queremos construirlo.A continuación, nos aparecerá una tabla de Jpivot por defecto, donde aparecerán todas las dimensiones de análisis definidas en el cubo y los indicadores por defecto, con una única linea de resultados totales. Este será el punto de partida sobre el que iremos puliendo nuestro análisis hasta dejarlo de la forma que cumpla nuestros requerimientos de información.

Esta tarea de modificación de los análisis no será siempre necesaria, pues una vez los tengamos preparados, los podremos guardar y reejecutar, manteniendo la configuración de dimensiones, jerarquías, filtros e indicadores de análisis que tuviera la tabla en el momento de ser guardada. Vamos a ver las diferentes opciones de la interfaz de usuario de Jpivot.

La interfaz de usuario de JPivot es muy sencilla. Básicamente, disponemos de una barra de herramientas con botones donde podemos configurar las propiedades que va a tener la tabla donde visualizamos los resultados de los análisis. Veamos uno por uno cada botón (de izquierda a derecha) de la interfaz de usuario.

Navegador Olap

El primer botón de la barra de herramientas es el navegador Olap que nos permite configurar como Jpivot muestra la información de los cubos en la tabla pivot. Con la herramienta podemos definir que dimension y jerarquia aparece en cada uno de los ejes (filas/columnas), los indicadores que visualizamos en el análisis, filtros, etc. Podemos ir moviendo los diferentes elementos de una sección a otra pulsando los correspondientes iconos a la izquierda de cada elemento hasta dejar el análisis personalizado a nuestra necesidades.

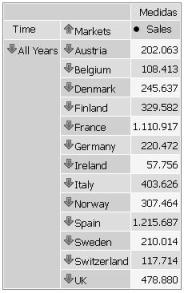

De esta forma, vamos configurando como será

la visualización en la tabla. Ademas, podremos modificar la jerarquía

visible en cada dimensión (en principio se verá la jerarquía por

defecto, para el caso de tener varias jerarquías en la misma dimensión).

También podemos seleccionar el nivel dentro de la jerarquía o los

elementos a visualizar de todos los disponibles.

Una vez realizadas las consiguientes

modificaciones en el layout, pulsaremos el botón Aplicar y los cambios

serán visibles en la tabla pivot.

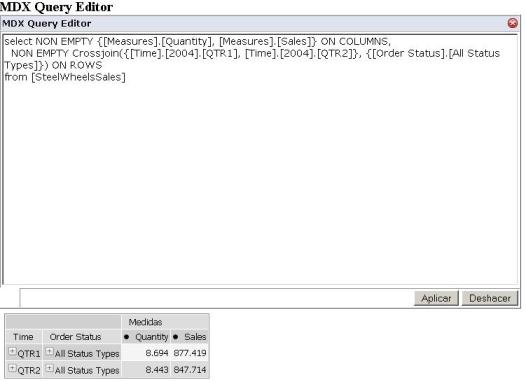

Editor MDX.

Como hemos indicado antes, conforme vamos

seleccionado las dimensiones e indicadores en el navegador olap, al

actualizar la consulta, internamente se traduce a lenguaje MDX que es el

que utiliza Mondrian para luego construir las sentencias SQL que se

ejecutaran contra la base de datos relacional. Con este control, podemos

visualizar la sentencia MDX que se ha construido de forma automática, e

incluso, si dominamos este lenguaje, escribir directamente las

consultas que darán como resultado la tabla pivot correspondiente.

Habrá que tener en cuenta en la sintaxis de las sentencias MDX

como hayamos llamado a las dimensiones, jerarquías e indicadores.

Podeis consultar sobre la sintaxis del lenguaje MDX en la

correspondiente página de Pentaho.

Propiedades de visualización.

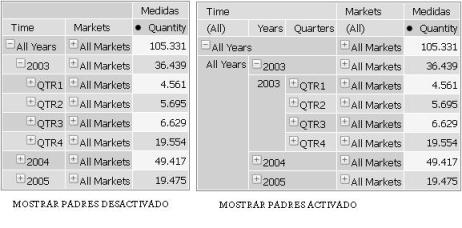

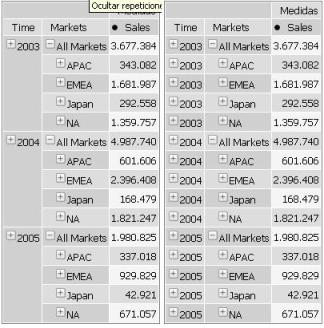

El siguiente grupo de iconos nos permite establecer propiedades de visualización de la tabla de pivoteo sobre los datos.

- Mostrar padres: podemos forzar la visualización de los elementos padre conforme vayamos profundizando en los datos.

- Ocultar repeticiones: con esta opción podemos ocultar repeticiones de los valores de los miembros de una jerarquía y asi hacer mas comprensible el análisis de los resultados.

- Suprimir filas/columnas vacias: oculta las filas o columnas que no tuviesen valores.

- Intercambiar ejes: nos permite de una forma rápida pasar las filas a columnas y viceversa, y así cambiar la forma de ver la información.

Opciones de navegación.

Una opción muy interesante es determinar la

forma en que se realiza la navegación por la tabla. Para ello, tenemos 3

posibles opciones.

- Detallar miembro: cuando navegamos por un miembro de una dimensión (por ejemplo, el mercado EMEA en la imagen anterior), independientemente de que estemos en un año u otro, se abre el desglose del miembro en todas las ocurrencias que tuviera en la tabla (en los diferentes años en el caso de nuestro ejemplo).

- Abrir detalle: en contraposición a Detallar miembro, con la opción Abrir detalle sobre se abre el nivel del miembro que hayamos seleccionado, no todas las ocurrencias.

- Entrar en detalle: cambiamos la forma de navegación, sustituyendo el icono + por una flecha, que nos permite ir bajando y subiendo por la información sin que se vaya realizando un desglose. Es una forma de navegación mucho más util para ir analizando aspectos concretos.

- Mostrar datos Origen: con esta opción mostramos en la parte inferior de la tabla pivote una tabla adicional donde se muestran los datos originales que dan lugar a los resultados mostrados en la tabla principal. Puede ser útil para buscar determinados valores en registros individuales de datos cuando se produzca una alarma visualizando los resultados de la tabla principal.

Modo gráfico y exportación PDF/Excel.

Finalmente, el ultimo set de botones de la

barra de herramientas nos permiten configurar el gráfico que se muestra

como complemento de la tabla pivot o realizar la exportación de los

resultados en formato PDF o Excel.

- Mostrar gráficos: al seleccionar la opción, se visualiza adicionalmente un gráfico con los resultados de la tabla. Los tipos de gráfico que se pueden utilizar son de barras, de linea, de area o de tarta.

- Configurar gráficos: en esta opción configuramos las propiedades del gráfico (tipo de gráfico, fuentes, titulos, color de fondo, etc).

- Configurar impresion: configuramos alguna de las propiedades que tendrá el PDF que se genere en la opción Exportar a PDF (titulo, tamaño de tabla, orientación del papel, etc).

- Exportar a PDF: genera un documento PDF con los resultados de la tabla pivot según la configuración indicada.

- Exportar a Excel: nos permite exportar la tabla de resultados visibles a un fichero con formato excel.

Otras alternativas. StPivot, Pat y Jrubic/La Azada.

Jpivot tiene una interfaz algo anticuada y no demasiado vistosa. Por este motivo, han surgido algunas alternativas que tratan de mejorar la experiencia de usuario al trabajar con Mondrian. Podemos destacar:- Stpivot: como lo llaman en Stratebi, es Jpivot con esteroides. Es una mejora de la interfaz de usuario y algunas funcionalidades realizadas por ellos. Os dejo el link al blog de todobi.com donde podeis ampliar información y ver videos de como instalarlo y utilizarlo.

- Jrubik/ La Azada: una opción alternativa a la utilización de PAS es utilizar un cliente Olap que ejecutaremos en nuestro PC como un programa más de escritorio. Un ejemplo de este tipo de aplicación es Jrubik, proyecto desarrollado en su día por gente de la Agencia Tributaria en España o el más actual La Azada, del que podeis leer mas en este documento publicado por todobi.com. Estan totalmente integrados con Mondrian, y aunque tienen algunas limitaciones y bugs, pueden ser una opción interesante.

- Pat (Pentaho Analysis Tool): es el nuevo proyecto que pretende crear la interfaz del futuro que sustituya a Jpivot. Esta todavía en una fase muy inicial y aun le queda un largo recorrido antes de ser una opción a considerar. Podeis ampliar información sobre el proyecto aquí.

17.4. Reporting en Pentaho con Pentaho Report Designer. Otras posibilidades de reporting (Birt y JasperReports).

Posted by Roberto Espinosa en 15 julio 2010

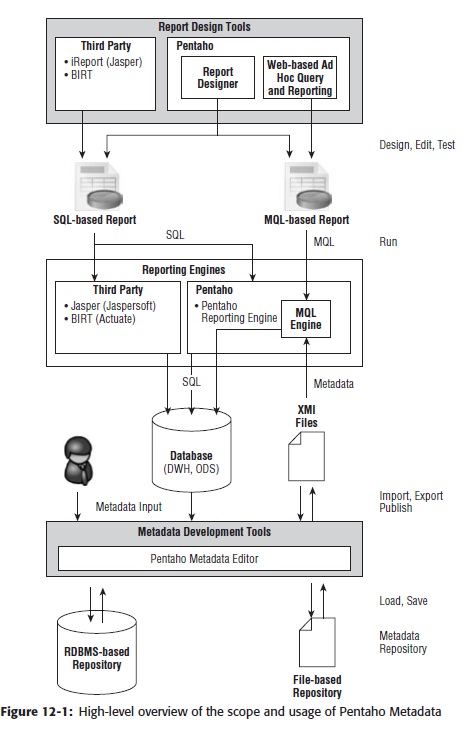

La plataforma Pentaho nos proporciona dos formas integradas de

realizar reporting, ademas de permitir la utilización e integración de

otras herramientas (como JasperReports o Birt). Las herramientas propias

de Pentaho, como ya vimos, son las siguientes:

El asistente dispone de 4 etapas, en las que realizaremos las siguientes acciones:

1) Select Data Source: realizaremos la selección del origen de datos que queremos utilizar. Dispondremos de tantos origenes de datos como Business Model o Modelos de negocio hayamos generado en la definición del Metadata. Seleccionaremos uno de los modelos y tendremos disponibles para los siguientes pasos todas las vistas de negocio y sus correspondientes campos incluidas dentro del modelo de negocio seleccionado. Además, podremos indicar un template o plantilla que nos determinará el formato que va a tener nuestro informe.

Antes de continuar, os hago una recopilación de la documentación que proporciona Pentaho en su portal Wiki con respecto al reporting.

A continuación vamos a realizar un ejemplo de utilización conectandonos a una base de datos Oracle para obtener diferentes informes de ventas, que nos permitira ver las funcionalidades básicas de PRD, así como todos los elementos que forman su interfaz de usuario.

Estructura de los informes.

Tal y como vemos en la imagen anterior, cuando creamos un informe partimos de una estructura estandar que incluye una serie de secciones que podremos utilizar o no. Las secciones mas habituales son las siguientes:

Componentes.

En la parte izquierda de la pantalla, disponemos de una barra de herramienta en las que tenemos los diferentes componentes que podemos utilizar al definir un informe (tal y como vemos en la imagen siguiente). Vamos a ver en detalle cada uno de ellos (de derecha a izquierda según aparecen en la imagen):

La parte más importante cuando estemos creando un informe es la definición del dataset, pues va a determinar los datos que vamos a poder utilizar dentro de nuestro informe. PRD nos deja trabajar con varios tipos de origenes de datos, como son JDBC, el Metadata de la plataforma BI, Pentaho Data Integration, origen de datos OLAP, fichero XML, etc. Vamos a ver un ejemplo sencillo utilizando JDBC como origen de datos.

Uso de parámetros y funciones.

Para poder definir restricciones a los datos que devuelvan los informes, PRD nos permite trabajar con parametros, que se nos pediran en el momento de ejecución del informe y que se podrán incluir en las condiciones de las querys definidas. Podremos definir diferentes tipos de parametros, desde lista simple, lista multiple, casilla de selección, radio button, etc. Los valores a mostrar en los filtros también se pueden hacer que sean determinados por el resultado de ejecución de una query contra base de datos (por ejemplo, una lista de provincias para determinar los resultados que queremos mostrar).

‘dim_date_en_us’.'year4′,

‘dim_date_en_us’.'quarter_name’,

‘dim_date_en_us’.'month_number’,

‘dim_date_en_us’.'month_name’

FROM

‘dim_date_en_us’

WHERE

‘dim_date_en_us’.'year4′ = ${param_year}

AND ‘dim_date_en_us’.'quarter_name’ IN (${param_quarter}) Observar el uso de un parametro que es una lista de valores en la ultima linea de la sentencia SQL, utilizando el operador IN para que un campo de una tabla se compare contra una lista de valores.

PRD también nos permite la utilización de funciones para realizar calculos y operaciones complejas (incluyendo la utilización de formulas al igual que vimos con PDI).

Uso de subinformes.

Otra característica interesante de PRD es la posiblidad de utilizar un informe dentro de otro informe (lo que llaman subinformes). Esto nos puede permitir superar las limitaciones que tiene un generador de informes del tipo Banded. Por ejemplo, lo podremos utilizar para mostrar diferentes vistas del mismo conjunto de datos. Cuando incluimos un subinforme dentro de otro, al hacer doble click accedemos al informe hijo para realizar su modificación y diseño.

Todos los elementos vistos hasta ahora tienen sus correspondientes tablas de propiedades donde podemos configurar su compartamiento, propiedades de formato y visualización, calculos, etc. Disponemos igualmente de una opción de previsualización para ver como quedaría el resultado del informe tras la fase de diseño.

Publicación y ejecución de informes.

Los informes que hayamos creado se pueden ejecutar directamente desde PRD o bien publicarlos en la plataforma BI, momento en el que ya estarán disponibles para ser usados por los usuarios (habrá que acordarse previamente de refrescar la cache del metadata en la plataforma para que tenga en cuenta y sea accsesible el nuevo informe).

- Web Ad Hoc Query and Reporting Client (WAQR): herramienta integrada en el portal que nos permite realizar querys y reporting adhoc de una forma intuitiva y sencilla, aunque con limitaciones.

- Pentaho Report Designer (PRD): a través de una herramienta de diseño desktop, que nos permite definir y construir nuestros informes, y luego publicarlos en el portal de BI para que puedan ser ejecutados por los usuarios.

Web Ad Hoc Query and Reporting Client (WAQR).

EL WAQR es la herramienta de reporting ad-hoc integrada en el portal BI de Pentaho. Accedemos a la herramienta desde la opción de menú Archivo –> Nuevo –> Nuevo report o pulsando el correspondiente Icono en la barra de la aplicación. En ese momento nos aparece un asistente que nos permitirá la construcción de los informes a partir de la información del metadata definida en el sistema (que habremos preparado previamente utilizando Pentaho Metadata Editor, como vimos en la correspondiente entrada del blog).El asistente dispone de 4 etapas, en las que realizaremos las siguientes acciones:

1) Select Data Source: realizaremos la selección del origen de datos que queremos utilizar. Dispondremos de tantos origenes de datos como Business Model o Modelos de negocio hayamos generado en la definición del Metadata. Seleccionaremos uno de los modelos y tendremos disponibles para los siguientes pasos todas las vistas de negocio y sus correspondientes campos incluidas dentro del modelo de negocio seleccionado. Además, podremos indicar un template o plantilla que nos determinará el formato que va a tener nuestro informe.

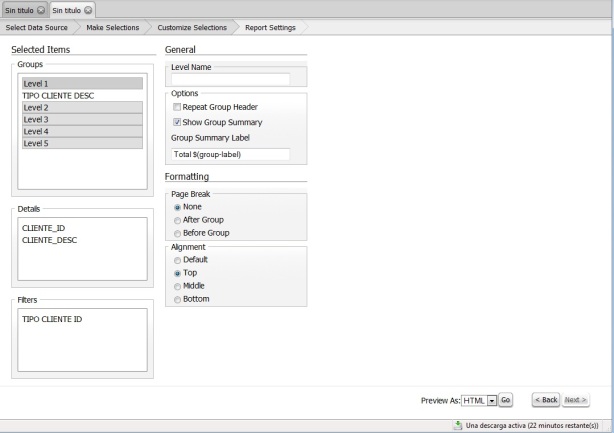

2) Make Selections: a

continuación, de todas las vistas de negocio incluidas en el modelo de

negocio seleccionado, configuraremos la disposición de los resultados

del informe, seleccionamos los campos oportunos de cada una de las

vistas de negocio disponibles. Seleccionaremos uno a uno los campos y lo

llevaremos a las secciones del informe que se encuentran en la parte

derecha de este. Tenemos 3 posibles secciones: Groups (campos con los

que realizaremos grupos de valores, pudiendo configurar hasta 5 niveles

de agrupación), Details (campos que formaran el cuerpo del informe o

detalle) y Filters (campos que se utilizaran para restringir los valores

devueltos en la ejecución).

3) Customize Selections:

en esta tercera pestaña configuraremos aspectos del formato de cada una

de las secciones del informe. Por ejemplo, en lo referente a las

agrupaciones (Groups), podremos indicar aspectos generales de como se

realiza el agrupado (nombre de nivel, repetición de cabecera de grupo,

mostrar sumario de grupo, etiqueta para el total por grupo, ruptura de

pagina o no en el grupo, ruptura de pagina antes o despues del grupo,

alineación, etc), tal y como podeís ver en la imagen siguiente.

Ademas, podemos indicar aspectos de

formateo, como mascaras de edición, alineación, forma de ordenación del

grupo, condiciones del grupo, etc, tal y como veis en la imagen.

Basicamente, tenemos los mismos componentes de formato si estuvieramos

modificando los campos seleccionados en la sección Details (detalles).

Para los campos insertados en la sección

Filters, podremos indicar constraints que serán condiciones que

limitaran los resultados devueltos por el informe.

4) Report Settings: este

será el último paso en la preparación del reporte adhoc. En este paso

final indicaremos la orientanción del informe, el tamaño de papel y la

configuración de la cabecera y pie de pagina del informe. En este

momento, el informe ya esta listo para su ejecución o para ser guardado y

reutilizado posteriormente por los usuarios.

Hemos visto que es una herramienta muy fácil

y sencilla de utilizar, y su potencia radica en que hayamos definido

correctamente en el metadata los campos a utilizar con las relaciones

definidas correctamente entre las tablas que son su origen. Aunque tiene

muchas limitaciones, nos puede sacar de un apuro y puede ser sin duda

facilmente utilizada por los usuarios finales. Ademas, los resultados

del informe los pondremos tener en HTML, PDF, Excel o CSV.

Pentaho Report Designer (PRD).

Pentaho Report Designer es una herramienta de reporting que nos permite crear nuestros propios informes, bien para ejecutarlos directamente o para publicarlos en la plantaforma BI y que desde allí puedan ser utilizados por los usuarios. La herramienta es independiente de la plataforma y forma parte del conjunto de herramientas de la suite de Pentaho.Antes de continuar, os hago una recopilación de la documentación que proporciona Pentaho en su portal Wiki con respecto al reporting.

User Guides

Blogs, Articles, How-Tos

- Diethard Steiner: Using Parameters in queries and datasources in Pentaho Reporting 3.5

- Diethard Steiner: Setting up an “All” Parameter

- Bart Maertens: Crosstabs in PRD-3.5

- Michael Tarallo: Guided Ad-Hoc with PRD-3.5

- MDX PARAMETER function

Books

- Pentaho Reporting 3.5 for Java Developers

- Roland Bouman, Jos van Dongen: Pentaho Solutions: Business Intelligence and Data Warehousing with Pentaho and MySQL

Developer Guides

A pentaho-reporting-sdk aimed at Java-Developers with simple demos, a detailed step-by-step guide and all the sources for all the libraries used in the demos is available from sourceforge.- How to configure Logging in Pentaho Reporting

- Dependency documentation

- Pentaho Reporting’s Modular Design

- Using the DocumentBundle Reader and Writer

- Parameter Definitions

- Report Processing State Diagramm

- Code-style Definitions

- Functions And Expressions

- DataSource MetaData, User-friendly column names and formatting information

- Aggregate Fields

- Drill-Linking

Installation Guides

User Guides

- URL Parameters for the Report Viewer Plugin

- Reserved Parameter Names

- Classic Engine Algorithm

- Layout Restrictions for Table-based and Plain-Text output

- Style-Keys Reference

- Subreport Guide

- Introduction to Report Pre-Processors

- Fonts: Export to PDF and missing Unicode characters

- Timeseries-Charting in Report-Designer

- Links and Drill-Down

- Using Self-Signed Certificates with SSL (HTTPS) Connections

A continuación vamos a realizar un ejemplo de utilización conectandonos a una base de datos Oracle para obtener diferentes informes de ventas, que nos permitira ver las funcionalidades básicas de PRD, así como todos los elementos que forman su interfaz de usuario.

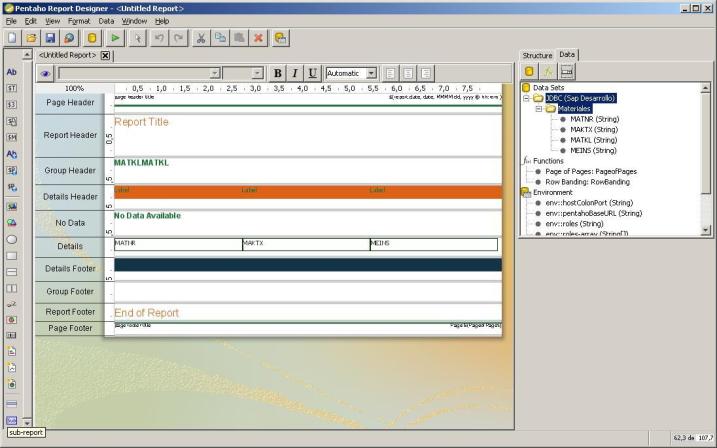

Estructura de los informes.

Tal y como vemos en la imagen anterior, cuando creamos un informe partimos de una estructura estandar que incluye una serie de secciones que podremos utilizar o no. Las secciones mas habituales son las siguientes:

- Page Header/Page Footer: el contenido indicado en estas secciones sera visible en cada una de las páginas del informe, en cabecera o pie de página según la sección seleccionada.

- Report Header/ Report Footer: el contenido indicado será visible solo una vez, al principio del informe o al final de este. Puede ser utilizado para indicar un titulo o un resumen del informe (en la primera página) o para presentar totales o conclusiones en la última página.

- Group Header/ Group Footer: cuando estamos trabajando con grupos de información, disponemos de estas dos secciones para abrir o cerrar cada grupo de información (sacar titulo al inicio o al final, subtotales, etc).

- Details Body: es la seccion que contiene la información detallada (fila por fila) recuperada de la base de datos. Tambien incluye las secciones Details Header y Footer para incluir cabeceras o titulos y pies.

- No Data: es una sección especial que se visualizara en el informe en el caso de que el set de resultados del informe este vacio.

- Watermark: es una sección especial que nos permite definir una marca de agua (o fondo) que se imprimira como base del informe en cada página de este.

Componentes.

En la parte izquierda de la pantalla, disponemos de una barra de herramienta en las que tenemos los diferentes componentes que podemos utilizar al definir un informe (tal y como vemos en la imagen siguiente). Vamos a ver en detalle cada uno de ellos (de derecha a izquierda según aparecen en la imagen):

- Etiqueta (label): elemento básico para añadir texto estático o etiquetas de columna en un informe.

- Campo Texto (text-field): para visualizar el contenido de campos de texto recuperados del dataset del informe.

- Campo Numérico ( number-field): para visualizar el contenido de campos numéricos recuperados del dataset del informe.

- Campo Fecha (date-field): para visualizar el contenido de campos de fecha recuperados del dataset del informe.

- Campo Mensaje (message-field): campo avanzado que nos permite combinar texto, referencias a campos y funciones en una única celda de datos. Por ejemplo, podremos definir un campo de este tipo con el contenido: “Cliente: $codigo_cliente domiciliado en: $poblacion”. Los campos precedidos por $ se refieren a campos del dataset.

- Etiqueta de recurso (resource-label): basandonos en un fichero de recursos, PRD puede traducir etiquetas de textos a otros idiomas.

- Campo de recurso (resource-field): idem que el anterior, pero para campos.

- Mensaje de recurso (resource-message): idem que el anterior, pero para mensajes.

- Campo Imagen (content-field): para visualizar campos del dataset que sean imagenes (recuperados, por ejemplo, de la base de datos).

- Imagen (image): visualiza una imagen proveniente de un archivo o de una URL.

- Elipse (ellipse): dibuja una elipse en el informe.

- Rectangulo (rectangle): dibuja un rectangulo en el informe.

- Linea horizontal (horizontal-line): dibuja una linea horizontal en el informe.

- Linea vertical (vertical-line): dibuja una linea vertical en el informe.

- Gráfico de escala (survey-scale): para dibujar un mini-grafico para representar una escala de 1 a 5.

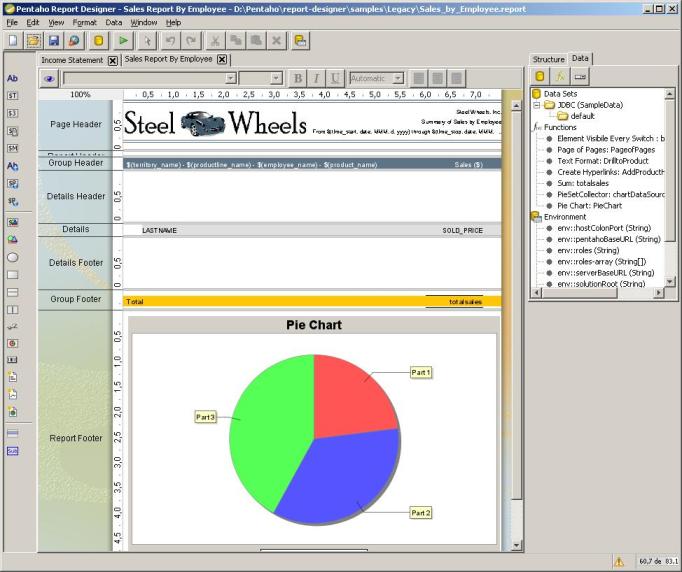

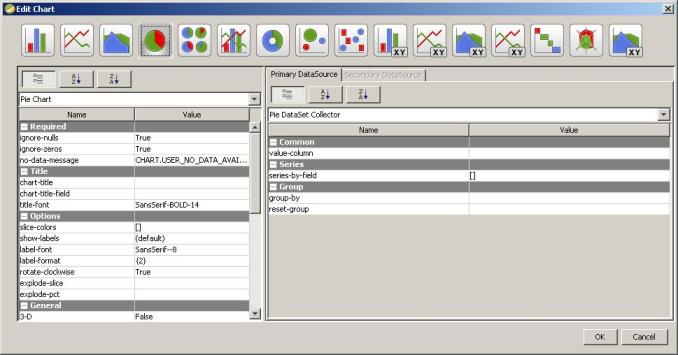

- Grafico (char): inserta un gráfico de análisis, que se podrá editar mediante el correspondiente editor. Nos permite crear gráficos de barras, de área, de tarta, de lineas, de burbujas, de anillo, radar, etc.

- Código de barras (simple-barcodes): traduce el contenido de un campo a un código de barras que podrá ser leido por un lector apropiado.

- Bar-sparkline,Line-sparkline, Pie-sparkline: para crear mini gráficos de barras, lineas o tarta.

- Banda (band): elemento para agrupar varios elementos y facilitar su formato de forma conjunta.

- external-element-field: válido para cargar subreports externos, desde una URL o desde una ubicación de archivos.

- SubInforme (subreport): nos permite incluir un subinforme dentro de la ejecución de un informe (y al que podremos pasar también parámetros del propio informe padre).

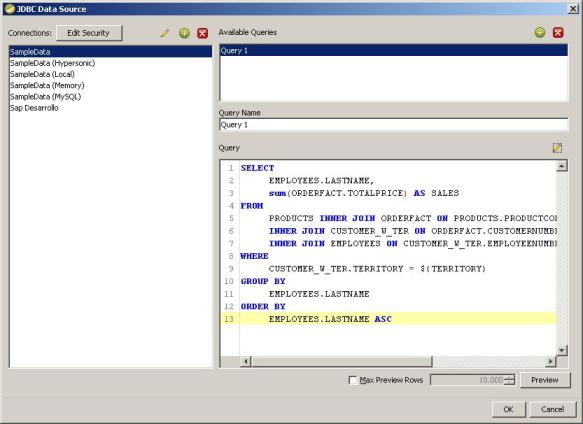

La parte más importante cuando estemos creando un informe es la definición del dataset, pues va a determinar los datos que vamos a poder utilizar dentro de nuestro informe. PRD nos deja trabajar con varios tipos de origenes de datos, como son JDBC, el Metadata de la plataforma BI, Pentaho Data Integration, origen de datos OLAP, fichero XML, etc. Vamos a ver un ejemplo sencillo utilizando JDBC como origen de datos.

En primer lugar, configuraremos el origen de

datos al que nos vamos a conectar utilizando JDBC. A continuación,

definiremos las querys que van a determinar los datos devueltos desde el

origen de datos, tal y como vemos en la imagen.

Para la construcción de las querys, tenemos

un asistente que nos permite ver las tablas disponibles e ir

construyendo las diferentes secciones de la sentencia SQL (Select, From,

Where, Group By, Having, Order by). Disponemos la opción Preview para

ir visualizando los resultados que devolvería la ejecución de la query.

Una vez concluida la definición de la query, nos aparece en la parte

derecha de la aplicación, en la sección Data (tal y como vemos en la

imagen siguiente). Tendremos todas las querys que hayamos definido y la

lista de campos que devuelve la query, para poder ser utilizados en las

diferentes secciones y controles del informe.Uso de parámetros y funciones.

Para poder definir restricciones a los datos que devuelvan los informes, PRD nos permite trabajar con parametros, que se nos pediran en el momento de ejecución del informe y que se podrán incluir en las condiciones de las querys definidas. Podremos definir diferentes tipos de parametros, desde lista simple, lista multiple, casilla de selección, radio button, etc. Los valores a mostrar en los filtros también se pueden hacer que sean determinados por el resultado de ejecución de una query contra base de datos (por ejemplo, una lista de provincias para determinar los resultados que queremos mostrar).

Para incluir los parametros en la ejecución

de las querys, utilizaremos la notación ${nombre_parametro} en el lugar

apropiado. Por ejemplo:

SELECT DISTINCT‘dim_date_en_us’.'year4′,

‘dim_date_en_us’.'quarter_name’,

‘dim_date_en_us’.'month_number’,

‘dim_date_en_us’.'month_name’

FROM

‘dim_date_en_us’

WHERE

‘dim_date_en_us’.'year4′ = ${param_year}

AND ‘dim_date_en_us’.'quarter_name’ IN (${param_quarter}) Observar el uso de un parametro que es una lista de valores en la ultima linea de la sentencia SQL, utilizando el operador IN para que un campo de una tabla se compare contra una lista de valores.

PRD también nos permite la utilización de funciones para realizar calculos y operaciones complejas (incluyendo la utilización de formulas al igual que vimos con PDI).

Uso de subinformes.

Otra característica interesante de PRD es la posiblidad de utilizar un informe dentro de otro informe (lo que llaman subinformes). Esto nos puede permitir superar las limitaciones que tiene un generador de informes del tipo Banded. Por ejemplo, lo podremos utilizar para mostrar diferentes vistas del mismo conjunto de datos. Cuando incluimos un subinforme dentro de otro, al hacer doble click accedemos al informe hijo para realizar su modificación y diseño.

Todos los elementos vistos hasta ahora tienen sus correspondientes tablas de propiedades donde podemos configurar su compartamiento, propiedades de formato y visualización, calculos, etc. Disponemos igualmente de una opción de previsualización para ver como quedaría el resultado del informe tras la fase de diseño.

Publicación y ejecución de informes.

Los informes que hayamos creado se pueden ejecutar directamente desde PRD o bien publicarlos en la plataforma BI, momento en el que ya estarán disponibles para ser usados por los usuarios (habrá que acordarse previamente de refrescar la cache del metadata en la plataforma para que tenga en cuenta y sea accsesible el nuevo informe).

Otras alternativas. Birt y JasperReports.

Ademas de las herramientas propias de Pentaho, la plataforma nos permite integrar con otras de las herramientas de reporting Open Source mas conocidas, como son Birt y JasperReports. Os dejo algunos links donde se explica la forma de configurar y ejecutar informes de Birt y Jasper en la plataforma BI de Pentaho.- Ejecución de informes BIRT en la plataforma de Pentaho: link.

- Ejecución de informes JASPER en la plataforma de Pentaho: link.

- Todobi.com: Integrando BIRT con Pentaho.

- Eclipse BIRT 2.5 and Pentaho 3.5 Integration and Configuration: link.

17.3. Preparando el analisis dimensional. Definición de cubos utilizando Schema Workbench.

Posted by Roberto Espinosa en 4 julio 2010

En lo referente al análisis dimensional, Pentaho nos proporciona en su plataforma BI una solucion ROLAP a través de lo que llaman Pentaho Analysis Services. PAS esta basado en Mondrian, que es el corazon de este, y en Jpivot,

que es la herramienta de análisis de usuario, con el que realizamos la

navegación dimensional sobre los cubos desde la plataforma BI y

visualizamos los resultados de las consultas. Estas son ejecutadas por

Mondrian, que traduce los resultados relacionales a resultados

dimensionales, que a su vez son mostrados al usuario en formato Html por

Jpivot.

Tal y como vemos en la imagen, donde se representa la arquitectura de Pentaho Analysis Services, el elemento principal del sistema son los ficheros xml donde se representan los esquemas dimensionales. Para construir estos ficheros xml, podriamos utilizar cualquier editor de texto o xml, o bien la herramienta que nos ofrece Pentaho, que se llama Schema Workbench. Pentaho Schema Workbench es la herramienta gráfica que permite la construcción de los esquemas de Mondrian, y además permite publicarlos al servidor BI para que puedan ser utilizados en los analisis por los usuarios de la plataforma.

En los ficheros de esquema XML, se describen la relaciones entre las dimensiones y medidas del cubo (modelo multidimensional) con las tablas y campos de la base de datos, a nivel relacional.Este mapeo se utiliza para ayudar la traducción de las querys MDX (que es el lenguaje con el que trabaja Mondrian), y para transformar los resultados recibidos de las consultas SQL a un formato dimensional. Vamos a ver a continuación como utilizar PSW para definir los esquemas de nuestro proyecto y publicar los resultados en el servidor BI. Más adelante veremos como funciona jpivot a nivel de frontend, para sacarle todo el partido a los análisis.

Vamos a ver a continuación las tareas básicas para definir un esquema utilizando PSW. Os recomiendo la lectura de la documentación Online de Pentaho referente a este tema antes de continuar, pues en ella se explican los conceptos básicos que tendremos que conocer para realizar el diseño de forma correcta.

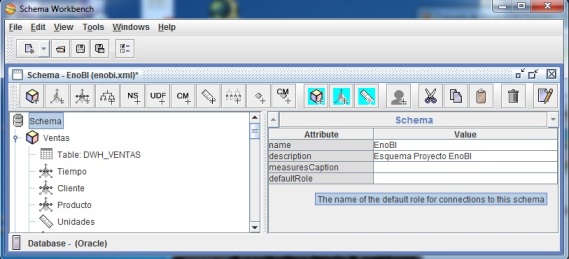

En primer lugar, procederemos a crear el Esquema. Un esquema es un contenedor de cubos (tendra un único fichero xml), donde podremos crear tantos cubos como deseemos. La propiedades que se pueden indicar al crear un esquema son un nombre, la descripción, un nombre para la dimensión que agrupara a las medidas y un rol por defecto para utilizar en las conexiones de base de datos. Como ayuda en este momento y en la creación del resto de elementos, podemos poner el ratón en el nombre del atributo a definir, y nos aparecera un texto explicativo de este (tal y como veis en la imagen siguiente).

Una vez creado el esquema, procederemos a la creación de los Cubos, aunque previamente hemos de hacer una consideración. En cada cubo, podemos definir la estructura de tabla de hechos, medidas, miembros calculados y dimensiones. La dimensiones y sus jerarquias podemos definirlas dentro de cada cubo, o crearlas de una forma general dentro del esquema, y luego utilizarlas en los cubos que nos interesen. Esto nos evita tener que definir varias veces lo mismo para cada uno de los cubos, así como reutilizar elementos ya definidos que se tratan en varios cubos. Esta será mi elección de diseño. Por tanto, antes de crear los cubos vamos a crear las dimensiones compartidas con sus correspondientes jerarquías.

Tal y como vemos en la imagen, donde se representa la arquitectura de Pentaho Analysis Services, el elemento principal del sistema son los ficheros xml donde se representan los esquemas dimensionales. Para construir estos ficheros xml, podriamos utilizar cualquier editor de texto o xml, o bien la herramienta que nos ofrece Pentaho, que se llama Schema Workbench. Pentaho Schema Workbench es la herramienta gráfica que permite la construcción de los esquemas de Mondrian, y además permite publicarlos al servidor BI para que puedan ser utilizados en los analisis por los usuarios de la plataforma.

En los ficheros de esquema XML, se describen la relaciones entre las dimensiones y medidas del cubo (modelo multidimensional) con las tablas y campos de la base de datos, a nivel relacional.Este mapeo se utiliza para ayudar la traducción de las querys MDX (que es el lenguaje con el que trabaja Mondrian), y para transformar los resultados recibidos de las consultas SQL a un formato dimensional. Vamos a ver a continuación como utilizar PSW para definir los esquemas de nuestro proyecto y publicar los resultados en el servidor BI. Más adelante veremos como funciona jpivot a nivel de frontend, para sacarle todo el partido a los análisis.

Pentaho Schema Workbench.

Como en todas las herramientas de Pentaho, en primer lugar hemos de definir las conexiones a base de datos como paso previo a la configuración de los esquemas. Además, hemos de colocar el driver jdbc en el directorio drivers que cuelga de la instalación de PSW. En nuestro caso, hemos configurado la conexión con Oracle de la siguiente manera:Vamos a ver a continuación las tareas básicas para definir un esquema utilizando PSW. Os recomiendo la lectura de la documentación Online de Pentaho referente a este tema antes de continuar, pues en ella se explican los conceptos básicos que tendremos que conocer para realizar el diseño de forma correcta.

En primer lugar, procederemos a crear el Esquema. Un esquema es un contenedor de cubos (tendra un único fichero xml), donde podremos crear tantos cubos como deseemos. La propiedades que se pueden indicar al crear un esquema son un nombre, la descripción, un nombre para la dimensión que agrupara a las medidas y un rol por defecto para utilizar en las conexiones de base de datos. Como ayuda en este momento y en la creación del resto de elementos, podemos poner el ratón en el nombre del atributo a definir, y nos aparecera un texto explicativo de este (tal y como veis en la imagen siguiente).

Una vez creado el esquema, procederemos a la creación de los Cubos, aunque previamente hemos de hacer una consideración. En cada cubo, podemos definir la estructura de tabla de hechos, medidas, miembros calculados y dimensiones. La dimensiones y sus jerarquias podemos definirlas dentro de cada cubo, o crearlas de una forma general dentro del esquema, y luego utilizarlas en los cubos que nos interesen. Esto nos evita tener que definir varias veces lo mismo para cada uno de los cubos, así como reutilizar elementos ya definidos que se tratan en varios cubos. Esta será mi elección de diseño. Por tanto, antes de crear los cubos vamos a crear las dimensiones compartidas con sus correspondientes jerarquías.

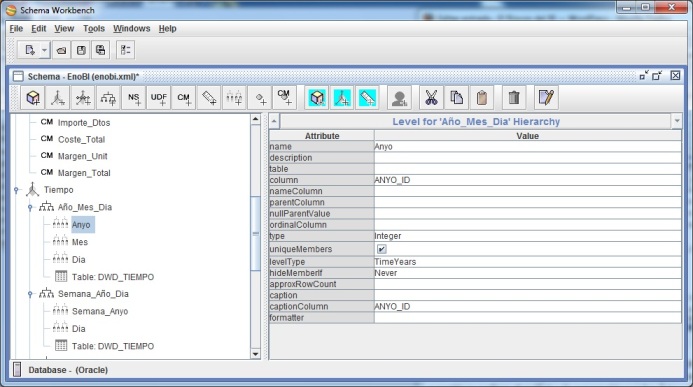

Creación de dimensiones compartidas.

Para añadir las dimensiones, seleccionaremos el esquema y pulsaremos la opción Add Dimension. Le daremos un nombre significativo a la dimensión, y seleccionaremos su tipo (TimeDimension en este caso) y una descripción.

A continuación, iremos creando las diferentes jerarquias

que tenga la dimensión. Por ejemplo, en nuestra dimensión tiempo

tenemos la jerarquías: Año – Mes – Dia, Semana – Dia, Año – Trimestre –

Mes – Dia, etc. Como veis, podemos tener tantas jerarquías como

deseemos. Las jerarquías son los niveles de análisis y detalle de la

información de nuestro modelo dimensional, que luego nos permitiran

realizar el análisis y la navegación por los datos utilizando Mondrian.

En cada jerarquía, indicaremos una serie de parámetros (importantes el

hasAll, si queremos que haya un agrupador de todos los valores de la

jerarquía, y su descripcion en el caso de que este marcado

(allMemberName)). Igualmente importante la clave de la jerarquía y una

descripción que luego nos aparecerá al configurar la ejecución del cubo.

Para cada jerarquía, indicaremos una tabla de la dimensión, y a continuación iremos creando los diferentes Niveles (levels)

que componen la jerarquía.Para cada nivel, iremos indicando la columna

de la base de datos que la describe, el tipo de datos, el tipo de nivel,

la columna que contiene la descripción, etc. Esto lo realizaremos para

cada uno de los niveles de la jerarquía. El orden con el que vamos

creandolos determina la estructura de la jerarquía.

Podemos tener tantas jerarquías como sea

necesario dentro de la dimensión. Luego podremos utilizar la que

deseemos a la hora de realizar los análisis (la primera será la

jerarquía por defecto). Una vez concluido el diseño de todas las

dimensiones con sus correspondientes jerarquías, ya podemos proceder a

la creación de los cubos.

Creación de Cubos.

Al crear el Cubo, le

indicaremos un nombre y una descripción, pudiendo marcar ademas las

opciones cache (para que Mondrian trabaje con cache en este cubo) y la

opción enabled (para que el cubo sea visible. Sino esta marcada este

flag, el cubo no aparecerá).

A continuación, seleccionaremos la Tabla de Hechos

del cubo (a partir de la cual podremos calcular las medidas o

indicadores). Antes de proceder a crear las medidas, seleccionaremos las

dimensiones que queremos incluir en el cubo, con la opción Add Dimension Usage.

Incluiremos todas las dimensiones necesarias(de las compartidas que

hemos creado antes). El cubo hereda todas las características que

hayamos incluido en la dimensión, incluyendo todas las jerarquías y sus

correspondientes atributos.

Como ultimo paso en la creación del cubo, nos tocará definir las Medidas, que van a ser los valores de análisis. Tenemos aquellas que se calculan directamente con campos de la base de datos, y los Miembros Calculados,

que son formulas en las que utilizamos otras medidas. Los atributos

que podemos indicar para las Medidas son su nombre, descripción, función

de agregación (suma, media, valor máximo, valor mínimo, contador, etc),

la columna que genera la medida, si es visible o no (puede interesar

que campos intermedios que se utilizan para otras medidas no se vean),

tipo de datos, formato y caption (nombre que aparecera cuando lo

utilicemos).

En lo referente a los Miembros Calculados, los

atributos están mas limitados. Podremos indicar su nombre, descripción,

caption (nombre que aparecerá en los análisis), si es visible o no, y

el atributo mas importante, la formula que genera el valor de la medida

calculada. Para indicar los valores de otras medidas, utilizamos la

notación [dimension_medidas].[medida]. Por ejemplo, para calcular el

importe bruto de ventas, la formula, siguiendo esta notación sera la

siguiente: [Measures].[Unidades]*[Measures].[Precio_Bruto]

Publicación del Esquema y utilización desde el portal BI.

Hemos visto los elementos básicos que

podemos utilizar en la definición de un esquema de Mondrian y sus cubos.

Disponemos de otros elementos, como los NS (Named Set) o los UDF (User

Defined Functions), así como los elementos virtuales (Cubos, Dimensiones

y Medidas), en los que no vamos a entrar en detalle. Tras construir el

esquema, el paso final para poder utilizarlo en los análisis del portal

BI de Pentaho es su publicación. Para ello, salvamos el cubo y

seleccionamos la opción de menú File –> Publish. Se nos pide la

dirección de publicación del servidor, la contraseña de publicación y

los datos del usuario. Se realiza la conexión con el servidor y el

esquema ya esta disponible para ser utilizado.

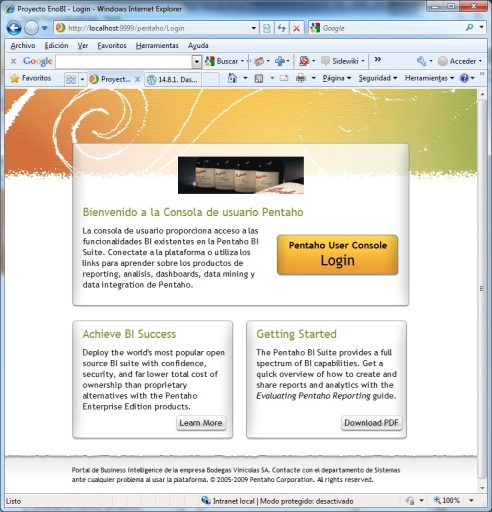

Accedemos al portal para ver si esto es asi. Al crear una nueva vista

de análisis, nos aparecen los diferentes esquemas disponibles, y ya

aparece el nuestro, ademas de los esquema de demostración que incluye el

servidor. Tal y como veis en la imagen, disponemos de nuestro primer

análisis. Aparecen todas las dimensiones (aunque solo se visualiza una

jerarquía por dimensión) y solo se ve una medida de todas las que

hayamos definido.

Aunque veremos más adelante todas las

opciones que podremos utilizar con Mondrian y jpivot, rapidamente

modificamos el análisis, modificando la configuración de las dimensiones

y los indicadores de análisis, y nos queda algo así. Hemos dejado solo

la dimensión tiempo, con la jerarquía Año-Mes-Dia partiendo del nivel de

mes, y hemos modificado los indicadores (medidas) que se visualizan.

Con la definición del metadatos que vimos en la entrada anterior del

blog, y la creación y publicación de los esquema de Mondrian que hemos

visto aquí, tenemos el portal de BI listo para profundizar en las

herramientas de reporting y para sacar todo el partido de los análisis

dimensionales. Estos son los aspectos que vamos a ver en profundidad en

las próximas entradas del blog.17.2. Preparando el reporting. Definición de metadatos con Metadata Editor.

Posted by Roberto Espinosa en 24 junio 2010

La plataforma Pentaho nos proporciona dos formas integradas de

realizar reporting, ademas de permitir la utilización e integración de

otras herramientas (como JasperReports o Birt). Las herramientas propias

de Pentaho son las siguientes:

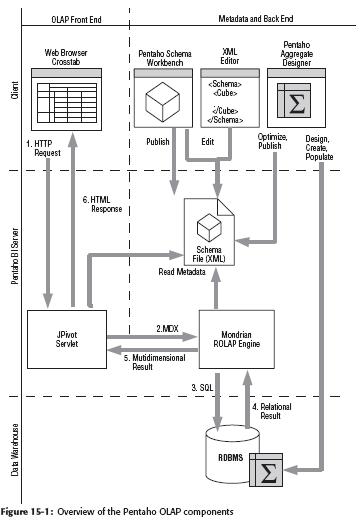

Veamos antes de entrar en detalle con Pentaho Metadata Editor cual es el planteamiento de Pentaho respecto a los metadatos.

El metadata de Pentaho esta basado en el estandar Common Warehouse Metamodel (CWM), que es una especificación creada y mantenida por el Object Management Group (OMG). Intenta ser un estandar abierto y neutral para permitir el intercambio y representación de metadatos en plataformas Business Intelligence (http://www.omg.org/technology/cwm).

El hecho de poner este nivel de metadatos por encima del nivel físico

de las tablas nos proporciona algunas ventajas bastante evidentes a la

hora de trabajar con nuestro sistema BI.

La construcción de los informes se realiza sin necesidad de ver el esquema físico de los datos, sino que utilizamos la definición que se haya descrito en el metadatos. Al ejecutar uno de estos informes, la definición de las querys se guardan en un formato llamado Metadata Query Language (MQL), que se resuelve contra el metadatos, y se traduce a nivel SQL para lanzar la consulta contra la base de datos en el lenguaje que esta entiende. Tenemos por tanto un motor MQL que se encarga de realizar este mapeo entre el esquema Lógico y el esquema Físico (tal y como podeis ver en la imagen anterior).

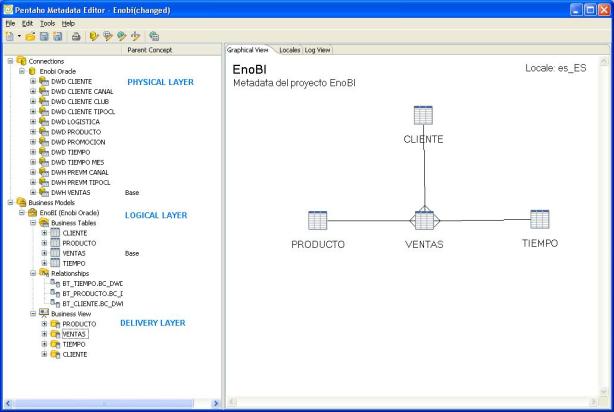

Podemos hablar de 3 niveles en la definición del metadatos: physical layer, logical layer y delivery layer.

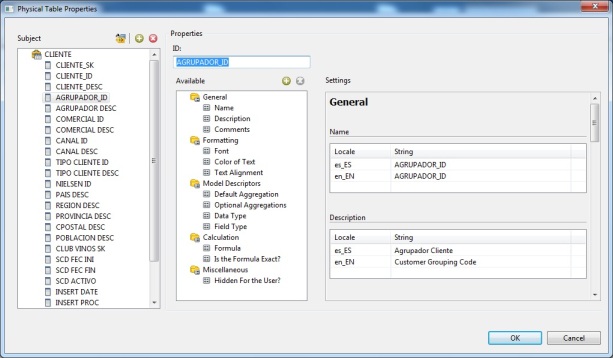

En primer lugar, tenemos el physical layer, que conocen los consultores de BI en profundidad (pues lo han diseñado y construido según los requerimientos). Corresponde a los campos y tablas de la base de datos. Estos objetos son los componentes que nos van a permitir construir el logical layer (pues no tiene sentido que los usuarios finales tengan que conocer como esta creada realmente la base datos).

En el logical layer, las tablas del nivel físico son redefinidas, y enriquecidas con columnas adicionales construidas a partir de las campos de las tablas y operaciones o expresiones sobre ellas. Ademas establecemos relaciones entre las tablas, que serán la forma de extraer información de forma conjunta (joins). Ademas, podemos crear varias tablas lógicas sobre la misma tabla física, para el tratamiento,por ejemplo, de las dimensiones role-playing (la misma tabla de dimensión juega diferentes roles).

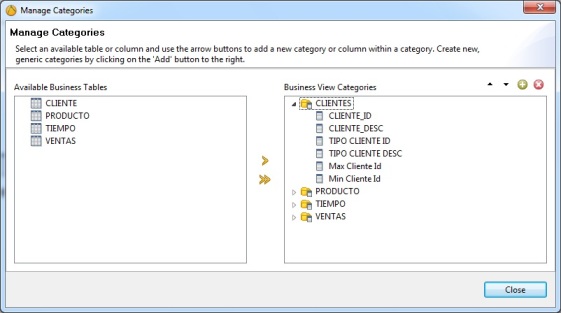

En el delivery layer se realiza una selección de columnas de la capa lógica y se agrupan en unidades que tengan sentido para el usuario de negocio (Business View). Esta es la única parte del metadatos que es visible para los usuarios finales, y partir de ella se realizará la construcción de los informes.

En todos los niveles, podemos definir diferentes elementos, que son principalmente conceptos y propiedades. Ademas, se puede establecer como los conceptos pueden heredar propiedades de otros. Veamos un poco más en detalle en que consiste esto:

Propiedades

Los objetos en el metadata pueden tener un gran número de propiedades. Las propiedades son items con nombres que se usan para asociar diferentes tipos de información a los objetos. Las propiedades se pueden dividir en categorias:

Conceptos.

Ademas de las propiedades, en el metadata de Pentaho podemos trabajar con una colección de propiedades y agruparlas en lo que llaman Concepto. Un concepto se puede aplicar a un objeto del metadatos, y sus propiedades son heredadas por el objeto. Por ejemplo, para todos los importes monetarios (que vamos a mostrar con un formato determinado de numeros decimales) o tipo de letra, podemos crear un concepto y luego aplicarlo a todas las columnas que queremos que compartan propiedades comunes. De esta forma, en lugar de modificar las características en los todos los objetos del metadata, lo haremos en los conceptos y asi nos aseguramos su consistencia y mantenerlo de una forma más fácil.

Herencia.

Las propiedades se pueden gestionar utilizando la herencia. La herencia ocurre basando un objeto (el objeto hijo) en otro objeto (el objeto padre). De esta forma, las propiedades del hijo y sus valores se construyen a partir de las del padre. Los cambios en las propiedades se transmiten en forma de cascada en la cadena de herencia.

Las propiedades que hereda un objeto se pueden quedar como las del padre, o bien ser modificadas y configuradas como una instanciacion propia de dichas propiedades. En ese momento se rompe la cadena de herencia de esa propiedad con respecto al padre. Cuando se modifique algo del padre, no se modificara la propiedad en el hijo. En Pentaho tenemos dos niveles de herencia:

Al trabajar con PME, podemos utilizar un repositorio local (a nivel de ficheros) o un repositorio de base de datos. El repositorio de PME es independiente del de la plataforma BI o el de Kettle, no tiene nada que ver. Se trabaja con el concepto de Dominio, que es un contenedor que incluye la definición del metadatos.

Los tres niveles que hemos indicado antes (physical layer, logical layer y delivery layer), se implementan de la siguiente manera.

A la hora de la construcción de los campos físicos, podemos definir

campos que sean operaciones entre varios campos o formulas. Para ampliar

la información sobre esta funcionalidad, podeís ver la documentación

Online de Pentaho.

Para trabajar con PRD no hace falta publicar en el servidor BI, sino que accedemos directamente al fichero xmi como origen de datos. Para verificar que el metadata esta correctamente importado en el portal BI, nos conectamos con nuestro usuario de pruebas y realizamos nuestro primer informe Ad-hoc. Todo se ha configurado correctamente.

Podeis ampliar información sobre todo lo visto en esta entrada del blog en la documentación online de Pentaho. A continuación vamos a ver como podemos definir nuestro esquema dimensional utilizando Pentaho Schema Workbench, lo que nos permitira posteriormente trabajar con los análisis sobre los cubos Olap.

- Web Ad Hoc Query and Reporting Client (WAQR): herramienta integrada en el portal que nos permite realizar querys y reporting adhoc de una forma intuitiva y sencilla, aunque con limitaciones.

- Pentaho Report Designer (PRD): a través de una herramienta de diseño desktop, que nos permite definir y construir nuestros informes, y luego publicarlos en el portal de BI para que puedan ser ejecutados por los usuarios.

Veamos antes de entrar en detalle con Pentaho Metadata Editor cual es el planteamiento de Pentaho respecto a los metadatos.

¿Que son los metadatos?

Como hemos visto en varias entradas del blog, los metadatos son información sobre los datos. Se utilizan en las herramientas ETL (como vimos al utilizar Talend), en las herramientas BI (como por ejemplo en Microstrategy) y Pentaho también tiene su propio enfoque.El metadata de Pentaho esta basado en el estandar Common Warehouse Metamodel (CWM), que es una especificación creada y mantenida por el Object Management Group (OMG). Intenta ser un estandar abierto y neutral para permitir el intercambio y representación de metadatos en plataformas Business Intelligence (http://www.omg.org/technology/cwm).

Ventajas del nivel de metadatos.

Ventajas del nivel de metadatos.

El hecho de poner este nivel de metadatos por encima del nivel físico

de las tablas nos proporciona algunas ventajas bastante evidentes a la

hora de trabajar con nuestro sistema BI.- Interfaz de usuario mas amigable: cuando trabajamos con bases de datos relacionales, se hace complejo la interrogación de la base de datos, pues hay que conocer en profundidad el lenguaje SQL (para sacarle todo el partido a las consultas) y también se hace necesario conocer la estructura física de las tablas. Al poner la capa de metadatos por encima, describimos las tablas, los campos y sus relaciones, y los podemos presentar al usuario de una forma mas comprensible para que construya sus propios reports sin necesidad de conocer la “compleja” realidad que puede haber detras.

- Flexibilidad e independencia del esquema físico: si tenemos un gran número de informes definidos en nuestro sistema BI, y es necesario cambiar la estructura física de los datos, esto nos obligara a modificar todo los informes para adaptarlos a esta casuística. Al tener la capa de metadatos por enmedio, en un caso como este, modificaremos su esquema con los cambios realizados sin necesidad de modificar los informes. En estos casos, la capa de metadatos nos va a ayudar a absorver el impacto de los cambios en el esquema físico de la base de datos.

- Definición de privilegios de acceso: normalmente, las bases de datos nos permiten establecer privilegios de acceso sobre los objetos o sobre las operaciones que se realizan sobre ellos. Pero no nos permiten establecer privilegios de acceso sobre la granuralidad de los datos (por ejemplo, limitaciones de lectura según las zonas geográficas, en un tipo ejemplo de informes para delegados regionales). Es decir, no tenemos un control de acceso a nivel de registro. A través de los metadatos, podemos establecer autorizaciones de este tipo bien a nivel de usuario o de rol (grupo de autorizaciones), para establecer politicas de acceso a los datos con alto nivel de detalle.

- Gestión de la localizacion (internacionalizacion): la definición de metadatos también nos puede permitir gestionar la internacionalización de un sistema BI, definiendo propiedades como etiquetas o descripciones de las tablas y columnas a nivel de idioma. Cuando se utilizen esos elementos en los informes, aparecerán en el idioma del usuario, recuperando las descripciones (apropiadas a cada lenguaje) del metadatos.

- Homogeneización del formateo de datos: en un sistema de reporting de BI, por ejemplo, puede ser aconsejable unificar la representación de los datos, especialmente en aquellos tipos de campos que necesita un formateo especial (importe monetarios, por ejemplo), con sus correspondientes indicadores de moneda, simbolo de decimales o de miles. Igual para el caso de links a otros informes o páginas (que se han de representar de una forma especial) o similares. El metadatos también nos puede ayudar en estos casos a definir un formato asociado a los campos, que luego se aplicara cuando sean utilizados en los informes.

Caracteristicas del metadatos de Pentaho.

Antes de ver como definir nuestro metadatos utilizando PME, vamos a ver como Pentaho utiliza esta capa en la práctica. Cuando definimos el metadatos, al terminar el proceso este queda archivado en un fichero .xmi (o a nivel de base datos, en el repositorio), y se exporta al servidor BI. En este momento ya puede ser utilizado por la herramienta de reporting Adhoc, o bien desde Pentaho Reporting Designer, para construir nuestro propios informes, utilizandolo como si fuese un origen de datos mas (como cualquier origen de base de datos relacional, por ejemplo).La construcción de los informes se realiza sin necesidad de ver el esquema físico de los datos, sino que utilizamos la definición que se haya descrito en el metadatos. Al ejecutar uno de estos informes, la definición de las querys se guardan en un formato llamado Metadata Query Language (MQL), que se resuelve contra el metadatos, y se traduce a nivel SQL para lanzar la consulta contra la base de datos en el lenguaje que esta entiende. Tenemos por tanto un motor MQL que se encarga de realizar este mapeo entre el esquema Lógico y el esquema Físico (tal y como podeis ver en la imagen anterior).

Podemos hablar de 3 niveles en la definición del metadatos: physical layer, logical layer y delivery layer.

En primer lugar, tenemos el physical layer, que conocen los consultores de BI en profundidad (pues lo han diseñado y construido según los requerimientos). Corresponde a los campos y tablas de la base de datos. Estos objetos son los componentes que nos van a permitir construir el logical layer (pues no tiene sentido que los usuarios finales tengan que conocer como esta creada realmente la base datos).

En el logical layer, las tablas del nivel físico son redefinidas, y enriquecidas con columnas adicionales construidas a partir de las campos de las tablas y operaciones o expresiones sobre ellas. Ademas establecemos relaciones entre las tablas, que serán la forma de extraer información de forma conjunta (joins). Ademas, podemos crear varias tablas lógicas sobre la misma tabla física, para el tratamiento,por ejemplo, de las dimensiones role-playing (la misma tabla de dimensión juega diferentes roles).

En el delivery layer se realiza una selección de columnas de la capa lógica y se agrupan en unidades que tengan sentido para el usuario de negocio (Business View). Esta es la única parte del metadatos que es visible para los usuarios finales, y partir de ella se realizará la construcción de los informes.

En todos los niveles, podemos definir diferentes elementos, que son principalmente conceptos y propiedades. Ademas, se puede establecer como los conceptos pueden heredar propiedades de otros. Veamos un poco más en detalle en que consiste esto:

Propiedades

Los objetos en el metadata pueden tener un gran número de propiedades. Las propiedades son items con nombres que se usan para asociar diferentes tipos de información a los objetos. Las propiedades se pueden dividir en categorias:

- Propiedades generales: como el nombre y la descripción.

- Propiedades de visualización: como fuente de letra, color, etc.

- Descriptores de modelo: expresiones, tipo de datos, reglas de agregacion, etc.

Conceptos.

Ademas de las propiedades, en el metadata de Pentaho podemos trabajar con una colección de propiedades y agruparlas en lo que llaman Concepto. Un concepto se puede aplicar a un objeto del metadatos, y sus propiedades son heredadas por el objeto. Por ejemplo, para todos los importes monetarios (que vamos a mostrar con un formato determinado de numeros decimales) o tipo de letra, podemos crear un concepto y luego aplicarlo a todas las columnas que queremos que compartan propiedades comunes. De esta forma, en lugar de modificar las características en los todos los objetos del metadata, lo haremos en los conceptos y asi nos aseguramos su consistencia y mantenerlo de una forma más fácil.

Herencia.

Las propiedades se pueden gestionar utilizando la herencia. La herencia ocurre basando un objeto (el objeto hijo) en otro objeto (el objeto padre). De esta forma, las propiedades del hijo y sus valores se construyen a partir de las del padre. Los cambios en las propiedades se transmiten en forma de cascada en la cadena de herencia.